Про це повідомляє “Kreschatic” з посиланням на HackerNoon

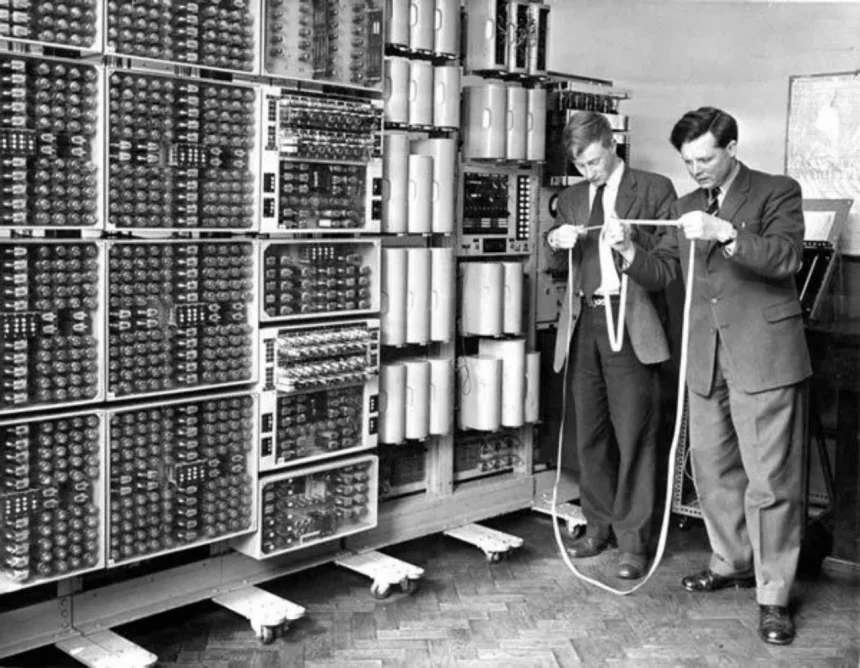

Тест Тюрінга, запропонований Алланом Тюрінгом у 1950 році, став важливим етапом в історії штучного інтелекту. Метою цього тесту було оцінити здатність машини до «мислення», де людина спілкується з обома — людиною та машиною — через текст. Якщо суддя не міг відрізнити машину від людини, то це означало, що машина демонструє розум. Однак, з часом, коли штучний інтелект досяг значних успіхів, виникає питання: чи є цей тест справжнім показником інтелекту?

Сьогодні штучний інтелект, зокрема моделі, як GPT-4, здатні вести складні, природні бесіди, що схожі на людські. Іноді вони настільки переконливі, що можуть пройти тест Тюрінга, не викликаючи сумнівів у непідготовлених користувачів. Проте багато вчених ставлять під сумнів, чи справді це свідчить про розуміння з боку машини, оскільки машинне навчання часто зводиться лише до імітації людської поведінки, без глибокого розуміння змісту.

Проблема імітації замість розуміння

Відомий термін «стохастичні папуги», введений у науковій роботі Бендера та інших, характеризує великі мовні моделі (LLM) як системи, які просто відтворюють статистичні патерни без реального розуміння. Такі системи можуть видавати правдоподібні відповіді, але вони не здатні насправді «розуміти» те, що говорять. Це ставить під сумнів можливість досягнення справжнього інтелекту машинами, оскільки вони лише оперують з даними без справжнього осмислення.

Проте є й інша точка зору. Деякі дослідники вважають, що в певних випадках такі системи можуть демонструвати ознаки розуміння. Моделі типу GPT-4 здатні розв’язувати нові задачі, пояснювати жарти чи писати код, що на перший погляд виглядає як прояв когнітивних здібностей. Це породжує запитання: чи може машина мати форму розуміння, навіть якщо вона не відтворює його так, як це робить людина?

Які реальні наслідки мають ці технології?

Це питання має практичне значення для компаній, які активно впроваджують штучний інтелект у свої продукти та послуги. Люди схильні надмірно приписувати розум до технологій, які можуть спілкуватися природною мовою. Відомо, що деякі розробники навіть стверджували, що їхні чат-боти є «сенситивними», наприклад, випадок з інженером Google, який переконував, що його чат-бот LaMDA має свідомість. Це явище може призвести до непорозумінь, особливо коли користувачі починають сприймати машину як «розумну» істоту, що здатна зрозуміти контекст проблеми.

У реальному житті це може мати серйозні наслідки. Коли штучний інтелект, який виконує роль консультанта чи служби підтримки, виглядає компетентним і доброзичливим, користувачі можуть припустити, що машина дійсно розуміє їхні потреби, хоча насправді модель просто використовує шаблонні відповіді, не маючи справжнього знання про предмет.

Потрібно переосмислити, що таке «розуміння»

Моделі, як GPT-4, змушують нас переосмислити саме поняття інтелекту. Вони підривають старе переконання, що тільки живі істоти можуть досягати справжнього розуміння. Можливо, машини здатні розуміти певним чином, який є незвичним для людського розуміння, і це не обов’язково повинно бути схоже на те, як працює людський мозок.

Однак важливо пам’ятати, що ці системи залишаються інструментами. Вони не мають досвіду, самосвідомості чи мотивації, які формують людське мислення. Без цих факторів машини не можуть відповідати вимогам, які ми ставимо до людей, коли мова йде про прийняття рішень або відповідальність.

Нагадаємо, раніше ми писали про те, як безкоштовний чат-бот перетворюється на інструмент стеження.